近日,浙江大学伊利诺伊大学厄巴纳香槟校区联合学院(ZJUI)王宏伟教授知识工程与知识系统实验室(DSKE LAB)的一项工作UniDCP: Unifying Multiple Medical Vision-Language Tasks Via Dynamic Cross-Modal Learnable Prompts,被期刊IEEE Transactions on Multimedia 接收(清华A类期刊,CCF-B类,IF:8.4)。该工作构建了一个具有动态跨模态可学习提示的统一医学视觉语言模型,可以在统一模型中灵活应用于多个医学视觉语言任务。该论文第一作者为DSKE LAB 2022级博士研究生詹晨璐,通讯作者为浙江大学王宏伟教授和王高昂助理教授。

论文简介

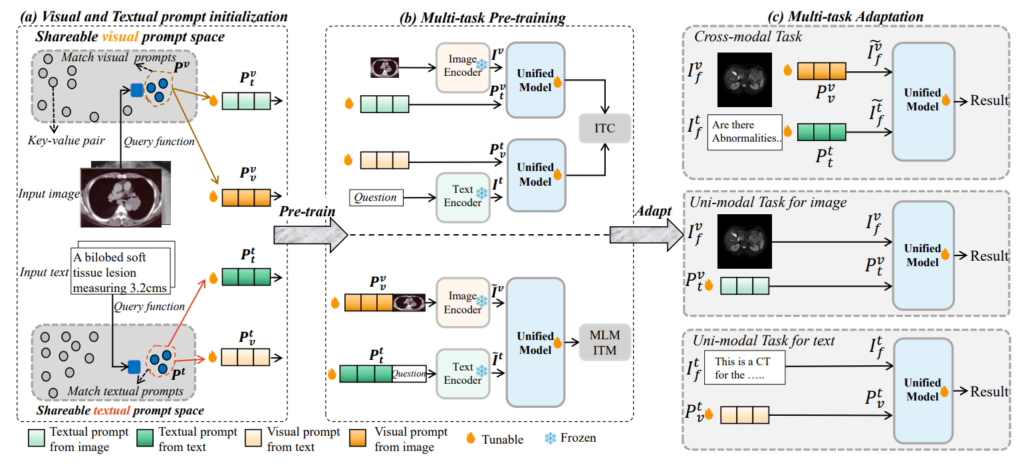

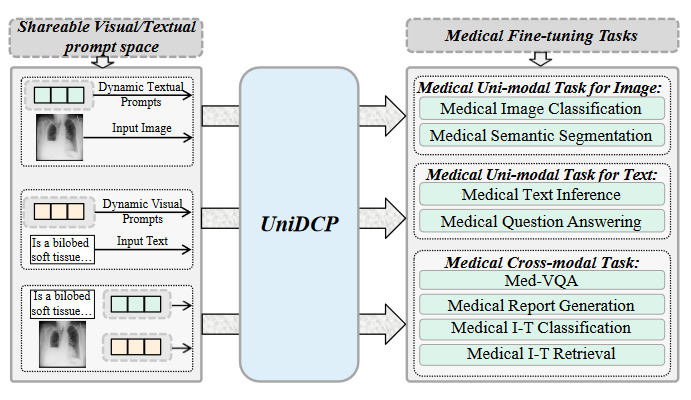

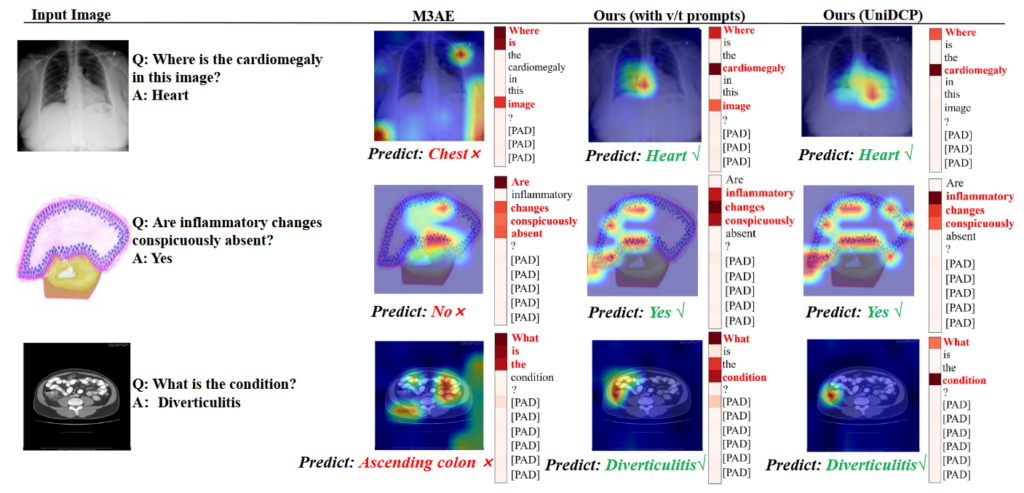

医学视觉语言预训练(Med-VLP)模型近年来加速了医学诊断应用的快速发展。然而,大多数 Med-VLP 模型都是从头开始独立学习特定于任务的表示,因此在跨多个微调任务工作时会导致极大的不灵活性。在这项工作中,我们提出了 UniDCP,这是一个具有动态跨模态可学习提示的统一医学视觉语言模型,可以在统一模型中灵活应用于多个医学视觉语言任务。具体而言,我们明确构建了一个统一的框架,通过利用跨模态提示进行统一来协调来自多个预训练任务的不同输入,从而可以容纳同一模型中的异构医学微调任务。此外,我们设想了一种动态跨模态提示优化策略,该策略优化可共享空间内的提示,以隐式处理可共享的临床知识。UniDCP 是第一个能够在8 个医学单模态和跨模态任务(14 个相应数据集)上执行的 Med-VLP 模型,并且始终比各种最先进的方法有着更优异的结果。

▲ 论文的主要框架

我们提出了一个集成且灵活的模型,具有低成本扩展性。1)集成:UniDCP在各种模态任务中具有更广泛的泛化性,没有特定于任务的模块,并在统一模型中实现了全面的SOTA结果。2)灵活性:我们提出动态提示,为每个任务选择语义上最有效的表示,它可扩展地适应各种任务,而开销可以忽略不计。我们的贡献总结如下:

-

我们提出了 UniDCP,这是一种统一的可塑模型,能够通过跨模式提示协调来自多个预训练任务的异构输入,从而执行多个医疗微调任务。

-

我们提出了动态跨模式提示在可共享空间内优化策略,以在不同任务转换下与可共享的临床知识配合。

-

UniDCP 是第一个 Med-VLP 模型,在 8 项医学视觉语言任务和 14 个基准上取得了最先进的结果,说明了将可共享的临床知识集成到多个任务中的优越性。

UniDCP能够执行多种医疗单模态和跨模态任务:

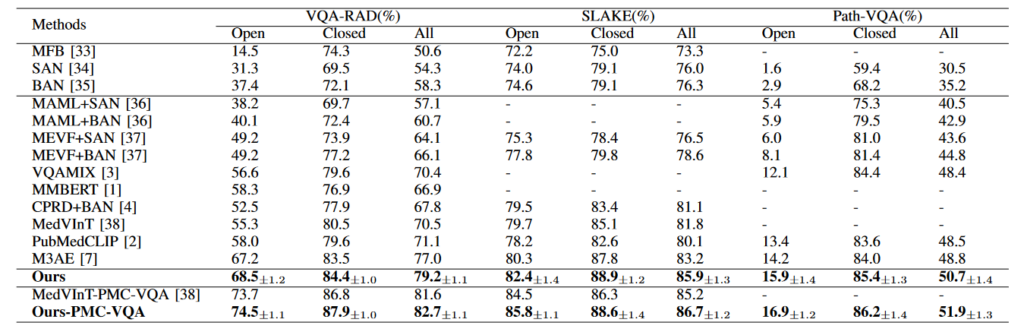

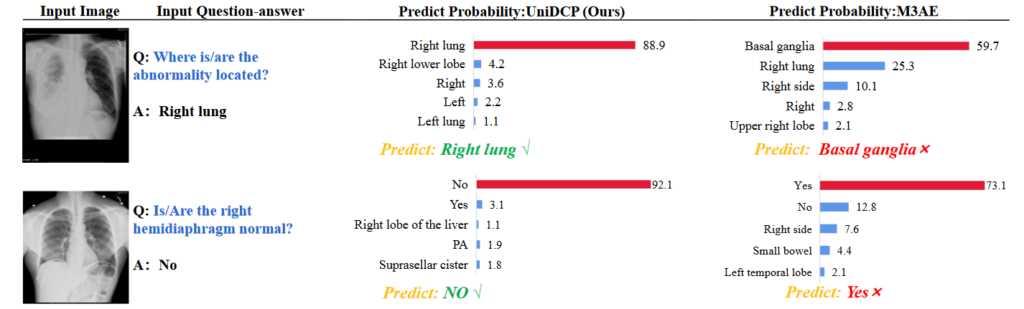

实验结果:

医学视觉问答任务定量比较分析:

作者信息:

詹晨璐, ZJUI和浙江大学计算机科学与技术学院计算机科学与技术专业联合培养博士研究生,导师为王宏伟教授和王高昂助理教授。研究方向为多模态、医学图像处理。

论文标题:

UniDCP: Unifying Multiple Medical Vision-Language Tasks Via Dynamic Cross-Modal Learnable Prompts

论文地址:

https://ieeexplore.ieee.org/abstract/document/10526408